Содержание статьи

- Почему представления об алгоритмах почти всегда упрощены

- Поиск как система интерпретации намерений

- Почему алгоритмы постоянно меняются, даже если это незаметно

- Различия подходов Google и Яндекса

- Почему алгоритмы нельзя «обмануть» в долгосрочной перспективе

- Как понимание алгоритмов влияет на стратегию SEO

- Заключение

Такое восприятие возникает из-за упрощённых объяснений, которые сводят сложные системы к спискам факторов ранжирования.

В статье разобрано, как на самом деле работают алгоритмы Google и Яндекса и почему их понимание критично для устойчивого SEO.

Почему представления об алгоритмах почти всегда упрощены

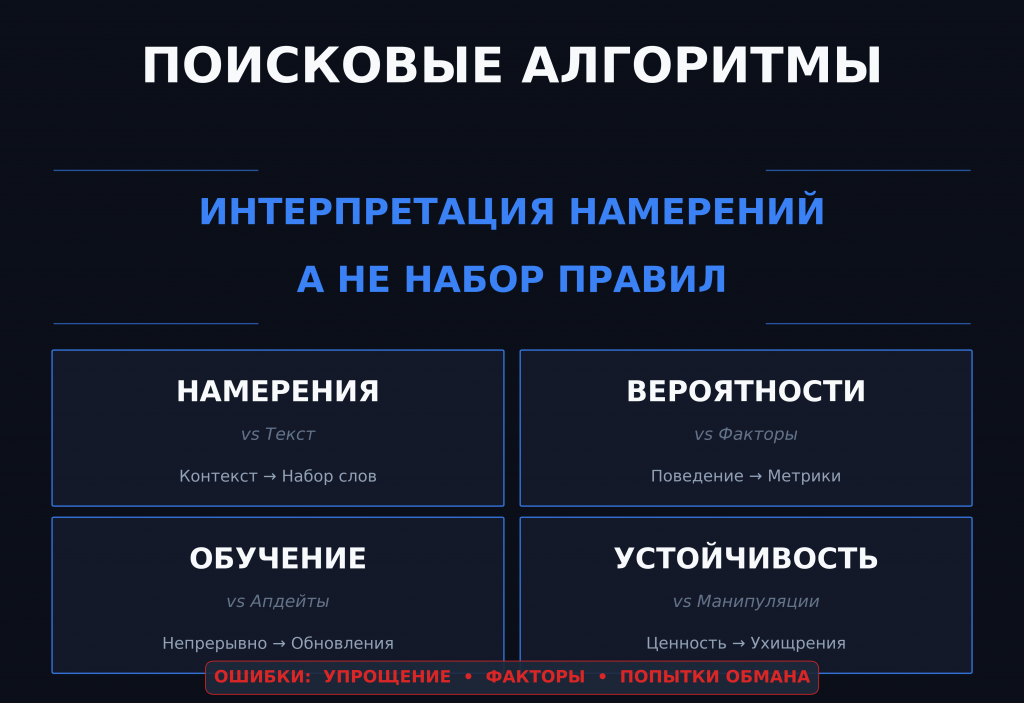

Когда говорят о поисковых алгоритмах Google и Яндекса, чаще всего имеют в виду не реальную систему, а её упрощённую проекцию. Алгоритмы представляются как некий набор правил, которые можно изучить, обойти или использовать в свою пользу. Из-за этого формируется ложное ощущение, что поиск — это механизм с понятной логикой входа и выхода: есть действия, есть реакция, есть результат. На практике поисковые системы устроены значительно сложнее и работают не как детерминированный код, а как постоянно обучающаяся модель, интерпретирующая поведение пользователей в масштабах, недоступных человеческому восприятию.

Эта ошибка восприятия особенно опасна на старте изучения SEO. Человек начинает искать «обновления алгоритмов», «факторы ранжирования» и «секреты продвижения», не понимая, что все эти элементы являются лишь внешними проявлениями более глубокой системы. Алгоритмы Google и Яндекса не оперируют категориями «хороший сайт» или «плохой сайт». Они работают с вероятностями, сигналами и корреляциями, которые отражают, насколько конкретная страница в конкретный момент времени соответствует ожиданиям пользователя по конкретному запросу.

Поиск как система интерпретации намерений

В основе работы поисковых алгоритмов лежит не анализ текста и не технические параметры сайта, а попытка интерпретировать намерение пользователя. Каждый запрос — это не просто набор слов, а контекстное выражение потребности, сформированной в определённой ситуации. Алгоритмы не знают намерение напрямую, но они обучаются на огромных массивах данных, связывая формулировки запросов с последующим поведением людей. Именно поэтому один и тот же запрос может со временем менять выдачу, а страницы, которые раньше ранжировались стабильно, постепенно теряют позиции.

Важно понимать, что Google и Яндекс не «решают», какой сайт лучше. Они выбирают наиболее вероятный вариант ответа, основываясь на накопленных сигналах. Эти сигналы включают в себя не только клики и время на странице, но и более сложные паттерны поведения, которые невозможно свести к одной метрике. Поэтому попытки оптимизировать сайт под отдельные факторы ранжирования почти всегда приводят к краткосрочным эффектам и не работают в долгую.

Почему алгоритмы постоянно меняются, даже если это незаметно

Существует распространённое заблуждение, что поисковые алгоритмы меняются только во время крупных апдейтов. На самом деле изменения происходят постоянно, просто большинство из них не выносятся в публичное поле. Алгоритмы обучаются на новых данных, корректируют веса сигналов и адаптируются к изменению поведения пользователей. Это не ручное обновление, а непрерывный процесс, встроенный в саму архитектуру поиска.

Из-за этого SEO невозможно зафиксировать в виде «актуального набора знаний». То, что работало год назад, может продолжать работать, но по другим причинам. Или перестать работать вовсе, не потому что было «запрещено», а потому что изменился контекст. Понимание этого принципа критически важно для формирования правильного подхода к SEO. Специалист, который воспринимает алгоритмы как статичную систему, неизбежно оказывается в позиции догоняющего.

Различия подходов Google и Яндекса

Хотя Google и Яндекс решают одну и ту же задачу, их подходы к интерпретации сигналов исторически различались. Это связано с особенностями рынков, языков и пользовательских привычек. Яндекс традиционно уделял больше внимания поведенческим факторам и локальному контексту, тогда как Google делал акцент на масштабируемых моделях оценки релевантности. Однако со временем эти различия сглаживаются, и оба поисковика движутся в сторону более сложных нейросетевых моделей.

Важно не зацикливаться на различиях как таковых. Гораздо продуктивнее понимать общее направление развития поиска: уход от формальных факторов, рост значения смысла, контекста и удовлетворённости пользователя результатом. Это означает, что оптимизация под конкретный поисковик всё чаще уступает место универсальному подходу, основанному на качестве и логике контента.

Почему алгоритмы нельзя «обмануть» в долгосрочной перспективе

Попытки манипулировать поисковой выдачей существуют столько же, сколько существует SEO. На коротких дистанциях они иногда дают эффект, что создаёт иллюзию возможности обмана системы. Однако в долгосрочной перспективе такие подходы почти всегда приводят к деградации проекта. Причина проста: алгоритмы обучаются на поведении пользователей, а пользователь невозможно заставить постоянно вести себя против своих интересов.

Если страница не решает задачу пользователя, никакие технические ухищрения не смогут удержать её в ТОПе надолго. Алгоритмы фиксируют несоответствие ожиданий и корректируют выдачу. Именно поэтому устойчивое SEO строится не на поиске лазеек, а на работе с реальной ценностью контента. Этот принцип лежит в основе современного подхода к поисковой оптимизации и является ключевым в системном обучении SEO.

Как понимание алгоритмов влияет на стратегию SEO

Понимание того, как на самом деле работают поисковые алгоритмы, меняет саму логику SEO-стратегии. Вместо фокуса на отдельных страницах появляется работа с тематическими кластерами, вместо оптимизации под ключевые слова — оптимизация под намерения, вместо реакции на апдейты — проактивное развитие сайта. Такой подход требует больше времени и аналитики, но именно он позволяет создавать проекты, устойчивые к изменениям алгоритмов.

В рамках курса «СЕО-продвижение» этому переходу уделяется особое внимание, потому что без понимания природы алгоритмов невозможно выстроить долгосрочную стратегию. Изучение отдельных факторов без системного взгляда приводит лишь к накоплению фрагментарных знаний, которые быстро устаревают.

Заключение

Поисковые алгоритмы Google и Яндекса — это не набор правил и не список факторов ранжирования, а сложные самообучающиеся системы, интерпретирующие поведение пользователей. Их невозможно полностью описать или предсказать, но можно понять принципы, по которым они развиваются. SEO, построенное на этом понимании, перестаёт быть набором приёмов и превращается в аналитическую работу с цифровым спросом. Именно такой подход позволяет создавать устойчивые проекты, не зависящие от очередного обновления алгоритмов.